转自公众号 腾讯研究院

没有发现很多聊天机器人其实很傻的?它们有时被称为“人工智障”,成为人们调戏的对象。而且当前AI基本上只能解决单一问题,比如自动驾驶汽车、会下围棋的阿尔法狗,还有AI诊疗等等,这一类智能只能完成一个既定目标,比如能下棋的不会开车,能开车的不会当医生。

其实,还有一类人工智能叫做通用人工智能(Artificial General Intelligence,AGI),或超级人工智能(Artificial Superintelligence),或强人工智能(Strong AI),指的是人类水平的人工智能,甚至比人类更聪明。

最近,麻省理工学院的物理学终身教授迈克斯·泰格马克写了本《生命3.0》的书火了,书中就提出当人类开发出这种通用人工智能超越人类智能的时刻,就是触发生命3.0产生的临界点,就是所谓“奇点”。这本书里总结了超级智能可能带来12种未来,4种截然不同的结果。

究竟人工智能可以帮助人类发展到什么极限?帮助人类走向哪里?那更多是留给科幻电影去畅想。本期腾研识者岳亚丁博士,则从技术可实现性的角度来和大家探讨,通用人工智能能否实现,什么时候能实现,技术上如何实现?可能遇到哪些困难?

文章要点:

奇点究竟何时来临?

当前AI与AGI的差距

AI向AGI的扩展及困难

实现AGI的技术路径举例

奇点究竟何时来临

算法工程师与朋友看了一场关于人工智能的科幻电影,在回家的路上,开始以下的聊天。

A:多年以前,我曾幻想,地球上几十亿人里面,说不定有一个长相、性格、习惯、爱好与我一模一样的,我还想过,如果我碰到了,能不能与他成为好朋友,或者我们会互相敌视。

B:这么多人里面,大概率你能碰上一个。之后你们之间会发生什么,就不好说了。

A:不说生物上的克隆技术,如今计算机越来越智能,没准将来能够造出来一个与我一模一样的机器人,甚至比我更强大、更聪明。我不知道应该是高兴,还是沮丧。

B:哈,受到电影的刺激了?你应该可以安心,电影里面的情节是虚构的,目前的计算机技术还远远没有发展到那一步。

A:那将来呢?

B:将来很难说。预测未来的错误率一般都是很高的。不过,的确有人言之凿凿给出了很具体的时间表预测。

A:谁?

B:未来学家、发明家、Google的工程总监Ray Kurzweil(雷·库兹韦尔)预测,2029年人类将无法区分与你谈话的是人还是机器(即能通过所谓的“图灵测试”),2045年将发生奇点。日本知名的技术和投资公司软银集团的CEO Masayoshi Son(孙正义)预测超级智能机器将出现在2047年。另一位未来学家、美国通用人工智能协会主席Ben Goertzel(本•古泽尔)则给出比较宽泛的时间窗,认为奇点位于2020到2100年之间。

A:什么叫“奇点”?

B:奇点(singularity)本来是一个数学名词,但是在这里,指的是一个时刻,过了这个时刻,人工智能就成为超级人工智能,其智力呈指数级地加速发展,自我完善也越来越快,最终就像拥有上帝的能力一样,达到无穷的智能。简单地说,奇点之后,计算机将比人更聪明。

A:这些人看起来都是有头有面的人物,想必有他们的道理吧。不过,我还是想知道,他们预测的依据是什么。

B:不迷信权威,好!我们来看看一些预测依据吧。

A:好的。

B:Kurzweil认为达到奇点的主要瓶颈之一是计算能力。我们知道,计算机界有一个著名的摩尔定律,大致说起来,就是集成电路的晶体管密度(同一面积下的晶体管数量)每两年翻一番。因此也可以大致认为,计算机的计算能力也是在指数级地增长。

A:我知道,指数级的增长,是挺吓人的。

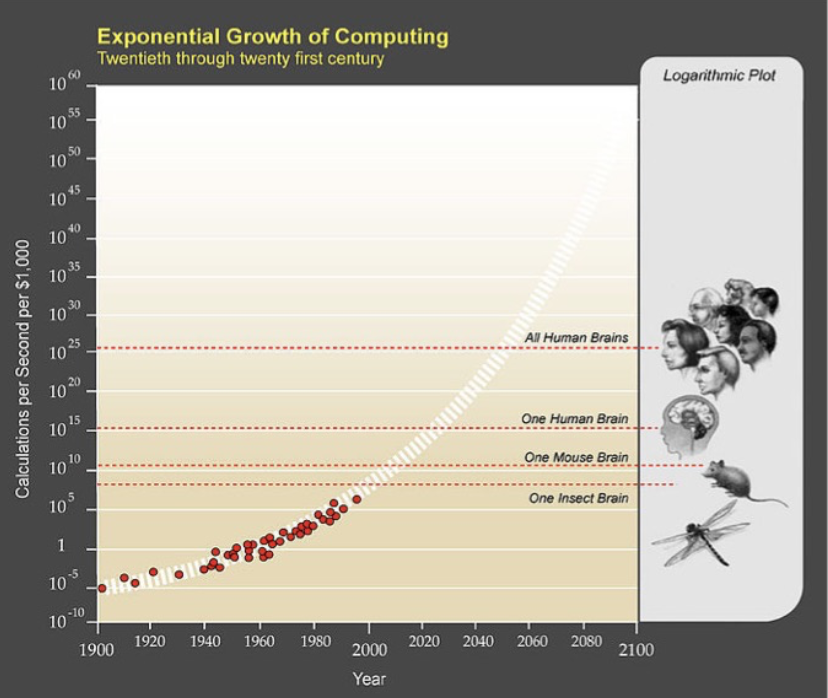

B:是的。虽然对于摩尔定律能否继续延续下去,还有很多争议 ,但是Kurzweil认为还会有新的技术冒出来,以维持计算能力的指数级增长。他综合别人的几种估计值,判断人的大脑的计算能力是每秒10^16(即10的16次方),及拥有10^13(即10的13次方)的存储空间,然后估计出:2020年花1000美元,就能买到相当于一个人脑的计算能力,而到了2045年,同样多的钱能够买到当今所有大脑加起来的计算能力的100万倍。因此他认为奇点将发生在2045年。

(图中显示随着时间推移,1千美元能买到的计算能力,即每秒计算次数)

A:好像做了不少的假设,才得到这个结论。还有别的依据吗?

B:Kurzweil还认为,要制造智能机器,首先要理解人类智能。其中的第一步,是大脑的成像。如今的正电子放射层扫描术(PET)、机能性磁共振成像(fMRI)的分辨率正在指数级增长,到了2020年代,纳米机器人从大脑内部扫描,还可以得到更多的细节。一旦知道了大脑的物理结构和连接信息,研究人员就可以做出包含整个大脑细节的一个功能性模型。除了以上对大脑的逆向工程(根据其结构反推如何实现其功能),他更是大胆判断,把一颗大脑里面的智力过程完整地拷贝到别处的技术,将在2040年前出现。

A:是够大胆的。

B:但是批评的声浪也不小。最常见的矛头指向所谓的指数级增长。有人指出,1969年人类首次登上月球,如果按照技术的指数级发展速度来估计,到现在早就应该有超大型的月球基地、飞向遥远星球的载人飞行了,但事实上还没有。

A:有很多实际情况,在预测时没有考虑到吧。

B:是的。即使对于所谓的大脑逆向工程,也有人指出,对大脑数据采集能力虽然随时间而指数级增长,但对大脑的生物学、遗传学的理解的速度,则要慢得多。

A:预测可能太乐观了。我甚至怀疑,人类能否预测奇点何时来临。

B:跟你一样,很多人对奇点能否预测,也提出了质疑。曾经有一家研究机构搜集了1950-2012年内科技文献中的257例关于人工智能的预测,其中95例给出了时间点预测,数据分析发现,其预测精度勉强比随机瞎蒙好一点点。且专家预测结果与非专家预测结果之间,没有明显的差别。还发现,大部分关于AI的预言,都落入一个模式:声称某个进展将在预测时刻之后的10-25年间出现。

A:这可真是令人丧气。对这类的预测结果,我们也许不能太当真了。

B:虽然很多预测不太靠谱,但是很多人还是相信,技术的加速度发展(指数级,或者非指数级),将会带来巨大的变化,最终奇点还是会出现的。早在1950年代,数学家、计算机理论科学家、量子力学的数学理论奠基人John von Neumann(冯·诺依曼)就指出:“不断加速的技术进步……给出的图景是会到达人类历史上的某个本质性的奇异点,之后人类的事务将不能继续。”

A:我也不否认这个大趋势。但是涉及到具体的时间点预测,这些未来学家的预测依据,可能还是过于局限在宏观层面了。我们可否从更微观层面进行考察?

目前AI离人类智能差多远

A:那我们先看看当前的AI技术发展现状吧,看看能不能体会到一些趋势性的东西。先问你一下,你对AI了解多少?

B:这个……我看到有人买了智能音箱教小孩子,一问一答的,好像挺有意思,不过玩多了,也显得有点笨;还听说计算机下围棋,已经打败世界冠军了;工厂里面或许可以用机器人代替工人;将来可以用无人机送货;汽车可以无人驾驶;军事上也可以用AI。这些都算是AI吗?

A:算的。他们都用到AI技术。其实归纳起来,目前的AI技术较多地针对三个方面:人类的语音处理(识别人类说的是什么,或者像人一样说出话来),自然语言处理(如文本的分类、摘要、生成,文章阅读理解等),图像视频处理(如图片中的人脸识别,视频中持续跟踪某个目标)等。

B:这三个方面,好像都是与人的感官有关系,听、说、读、写、看嘛。

A:是的,首先要保证人与机器能够沟通,然后让机器尽量像人一样处理信息,才能谈得上智能。

B:更深层次的,还有什么?

A:北京大学的高文院士指出,人工智能还应该研究:推理、知识、规划、学习、交流、感知、移动、操作等。按照哈佛大学一位心理学家给出的定义,智能至少涉及9个方面:逻辑方面的能力、语言文字方面的能力、空间改革的能力、音乐能力、肢体运作能力、内省的能力、人际关系能力、自然探索能力、图形图像理解的能力。你看看下面这张图。

(高文教授认为蓝色已经做得比较好,红色马马虎虎,橙色还完全不行。)

B:看起来,任重而道远啊。

A:是的。但即便如此,计算机科学家们在AI的基础—— 机器学习领域,还在努力发展新理论、新技术,向这些更高的目标艰难地推进。

B:你能举几个例子吗?让我增加一点信心。

AI向AGI的扩展及困难

A:首先,关于推理。在现有的机器学习系统中,大多数没有能力去理解概念之间的关系。例如,视觉系统可以识别图片中的狗或猫,但它不会知道图片中的狗在追逐猫。2017年DeepMind研发了关系推理系统,人们可以询问系统某个物体是否在另一个物体之前,或哪一个物体最接近另一个物体,系统的表现比以往任何同类系统都要好,在某些情况下甚至超过了人类的表现。

B:听起来很酷。

A:但是,研究人类智慧的哈佛大学心理学教授Sam Gershman也警告说:不要夸大DeepMind工作的意义。他说:“任何特定机器学习任务的超人表现都不意味着超人类的智慧。” 他又说:“对于人类智慧来说,关系推理是必要条件但不是充分条件。”

B:每时每刻,都有泼冷水的人啊。但这毕竟是机器推理能力的一个进步吧。

A:第二,关于数据不多时的学习能力。早在2016年南京大学周志华教授就指出,机器学习的主要局限之一,就是需要太多的数据。去年清华大学邓志东教授也表示,小数据学习才是AI崛起的关键。

B:什么是小数据学习?能举个具体的例子吗?

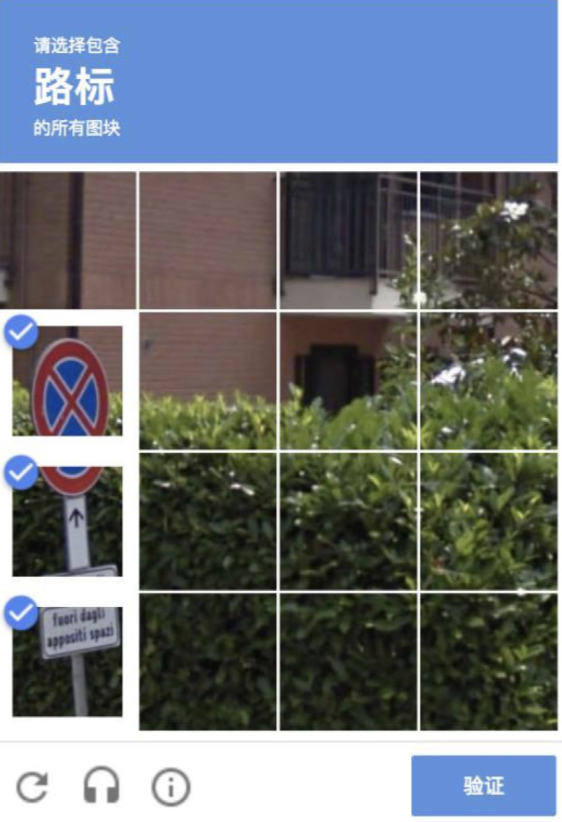

A:以图像识别为例,一旦把图像本身放到具体环境中,由于发生了变形、遮挡或者反光等,现在的算法就难于将它准确识别出来。举个例子,在使用Google 搜索时,很多人可能遇到过一种人机身份验证方式:在下列图片中选出含有交通标志的那些,如下图所示:

B:嗯,这种人机身份验证方式,我也碰到过。当然,我是靠我自己的眼观察,然后用鼠标去点击。不清楚用算法去做会怎么样。

A:以往的算法需要790 万张图片的训练,才能达到一定的识别精度。而借鉴哺乳动物视觉皮层处理图像的原理,建立类似的AI 模型,其训练量仅仅只要1406 张图片,就可以达到同样的识别精度。这就是小数据学习了。

B:的确是一大进步。

A:还有人分析了为什么人能够只需要很少样本数据,就能学会,例如我们看到一个人,就能记住他的样貌,并在下一次认出对方。看iPhone X 一眼,然后之后就可以认出它。

B:的确,人有这个能力。

A:分析的结论是:我们人的视觉系统天生的能够对任意物体提取特征,并进行比较。因为我们能够比较不同物体,所以我们根本无所谓看到的东西是不是以前就见过。这就是我们人具备少样本学习能力的关键原因。受此启发建立的AI模型,对5 个新类别的物体进行识别,但是每一类物体我们只给出一个样本,也能够得到很高的识别精度。

B:好像有人提到过,传统的神经科学为人工智能的发展提供了灵感。看来所言不虚。

A:第三,关于机器学习的自动化。现在AI人才炙手可热,人才严重缺乏,不能满足需求,于是有人琢磨,能不能让机器来代替AI算法工程师,自动地建立模型、构建算法。

B:哈,AI人要自己革自己的命了。

A:这样做,不仅仅是为了节省人才,也是为了更全面地探索各种可能性,自动地找出人类还无法想象出来的新模型及算法。

B:这也应该是未来超级人工智能所必需的吧。

A:对。学习的自动化,就是关于算法的算法,即用另一个算法来指导算法更好地学习,从而得到更好的算法。

B:结果怎么样?

A:初步结果令人振奋。Google按照这个思路,自动进化出一个神经网络,用于图片分类,精度非常高。华为将这个思路用于个性化推荐系统,实验中得到很低的预测误差。此外,阿里云有专门团队在做这个,腾讯也于2018年9月宣布已经建成自动化机器学习系统。

B:我提一个问题:那个打败围棋世界冠军的机器,AlphaGo,以及后来完全不参考人类棋谱、自学成才的版本,既然那么厉害,能不能用它来建立超级人工智能呢?

A:它们已经是成品,说用它来建立超级人工智能,就好比说,拿一辆汽车来建造一辆火车了。

B:那它的底层技术,能否用来建立超级人工智能?

A:的确有人想过,但是很遗憾,这条路是不靠谱的。

B:为什么?

A:我们不需要去了解它们的技术细节,只需要想到它们的底层技术所针对的,仍然是一组有固定规则的游戏,且这些游戏具有有限个可能的构型(围棋的盘面种类最多有3^361(即3的361次方)个,即大约10^171(即10的171次方)个),而其它领域的问题则可能没有这些条件,就能明白,它们的底层技术不是那么容易地推广到更广泛的场景去了。

B:喔,此路不通了。

A:所以,上面举的那些AI进展的例子(推理、小数据学习、机器学习自动化),以及下棋的计算机,虽然是AI领域的重要突破,但是它们都是从下而上地、从特例到一般的扩展,与我们想要的人类级别的人工智能,还有很大的差距。

B:那么,还有什么别的途径,能够帮助我们走向通用人工智能吗?

对通用人工智能(AGI)的直接研究

A:与AI研究并行开展的,是另有一拨人在直接研究AGI的模型。他们从一开始就没打算从现有AI中吸取什么,也没打算把现有AI技术推广到AGI。

B:哦?他们怎么做?做得怎么样?

A:其中一条路线是这样:我们在前面讨论中提到,超级人工智能的一个特点,是它们能够自我完善。设想一个计算机程序,如果它能够自己修改自己,岂不是就能自我完善了?

(在一个“递归自参考普适问题求解器”的指引下,机器人骑着机器人走向落日余晖。)

B:这怎么理解?

A:打个比方:我们每个人就是一段计算机程序,如果我看不顺眼我自己,觉得我的手臂不够长,那我就可以自如地把它变长一点;如果我想到水底长时间潜泳,那我就让自己长出一个鱼鳃。这就是自我完善了。

B:这当然很理想了。问题是能做到吗?

A:理论上是有可能的,但在现实中,还没有建造出来。

B:为什么?

A:简单说来,对于如何实现完全的自我反省(self-reflection)机制,以及如何提高求解算法的效率,都还有很多研究工作需要做。而且,所需要的计算资源也是空前巨大的。总之,还处在艰难、缓慢的探索中。

B:沿着这个思路,能否到达人类水平的AGI呢?

A:普遍的看法是:目前仍不能确定。但这是一个大胆的策略,它不需要关心人类大脑的某些特性,而是集中精力考虑了通用智能的数学本质。

B:看来,要做出来超级人工智能,真的很难啊。

A:所以,当前现实是,机器学习领域内的研究人员大多不主张研究通用人工智能,他们追求的往往是在特定的研究问题上取得进步。

B:还是有点不甘心,科学家们总还是得做点什么吧。

A:科学家们从来没有停止努力的步伐。的确,要构建通用人工智能系统似乎还很遥远,但反过来想想在五年前,二十年前,它不是更加遥远吗?

B:我们拭目以待吧。

该贴被huang.wang编辑于2018-10-31 16:46:41

技术讨论

技术讨论