本文转自机器不学习网站

深度学习似乎进入了“泛模型”阶段,同一个问题可以用不同深度学习结构解决,但是没有人可以证明哪个模型一定最好。

最近读到文章说“TCN(时间卷积网络)将取代RNN成为NLP预测领域王者”。一方面想为RNN抱不平,请大家别过于迷信CNN,毕竟只是一种特征提取方法,不必神话它(想想当年有人认为SVM可以解决所有建模问题)。

另一方面,可以感受到深度学习进入了“泛模型”的阶段。模型的结构创新没有衰退的趋势,而这些创新不出意料很快会被其他模型超越。这些“超越”都是实验与经验上的“超越“,没有SVM这样扎实的理论。

回顾历史可以发现,广义的计算机”模型“一直在”向上”做更灵活的事情。

ML时代那些机器学习”模型“(SVM,随机森林)一般只做最后的分类、聚类或回归;现在深度学习时代“模型”(以CNN、RNN为主)把特征提取的工作也一并做掉了。可以预见,未来物联网IOT发展到一定阶段,我们需要更复杂“模型”去自动收集数据,具体是什么形式的“模型”我们可以拭目以待。

言归正传,今天 要把TCN(时间卷积网络,CMU的研究总结)这个“坑”给填了。其实TCN只是一维卷积变形之后在时序问题上变得适用(以前也讲过一维卷积):

来自论文:An Empirical Evaluation of Generic Convolutional and Recurrent Networks for Sequence Modeling

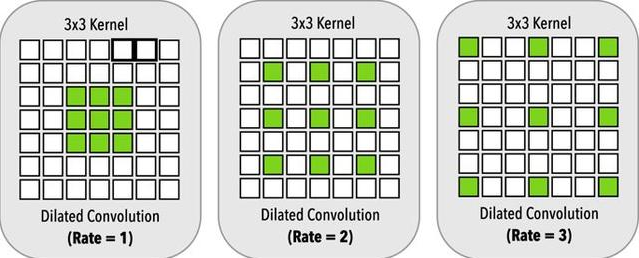

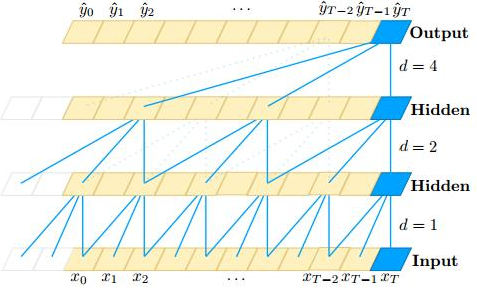

仔细观察就可以发现,TCN的卷积和普通1D卷积最大的不同就是用了扩张卷积(dilated convolutions),越到上层,卷积窗口越大,而卷积窗口中的“空孔”越多。

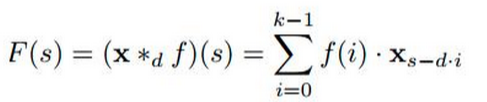

上式是扩展卷积操作的式子,其中d是扩展系数(即评价“空孔”的多少)。

为什么要这样 ? 还不是因为要适应时序问题的应用 !

时序问题有两个关键要求:

1. 网络输入x0, . . . , xT 的时序数据,我们希望输出也是一样大小的 y0, . . . , yT 的预测。扩张卷积可以做到每一层隐层都和输入序列大小一样,并且计算量降低,感受野足够大。

2. 时序预测要求对时刻t 的预测yt只能通过t时刻之前的输入x1到xt-1来判别(像隐马尔科夫链)。这在CNN里面就叫做因果卷积(causalconvolutions)。本质上,David 9认为就是通过限制卷积窗口滑动做到的。

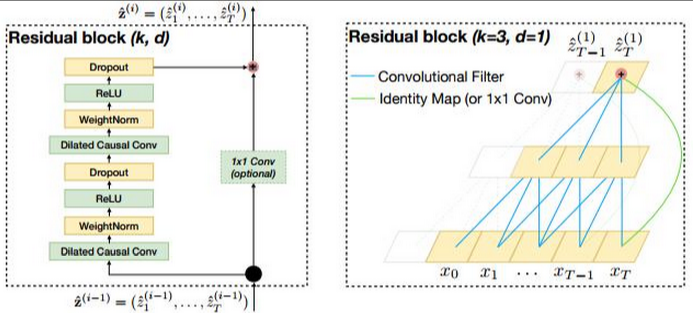

然后,TCN还为了提高准确率,还加入了残差卷积的跳层连接,以及1×1的卷积操作:

来自论文:An Empirical Evaluation of Generic Convolutional and Recurrent Networks for Sequence Modeling

残差卷积无需多讲,把下层特征拿到高层增强准确率。为什么要1×1卷积呢?我们以前提到过,1×1卷积是可以用来降维的 。所以David 9的理解是,作者直接把较下层的特征图跳层连接到上层,对应的每个Cell的特征图数量(也就是通道数channel)不一致,导致不能直接做类似Resnet的跳层特征图加和操作,于是,为了两个层加和时特征图数量吻合,用1×1卷积做了一个降维的操作。

可以看到TCN只是一维CNN的一个结构创新。广义上,自动提取特征信息至今仍是一个非常灵活难以把握的问题,虽然现在TCN可以与RNN在时序模型上有相当或者更出色的性能,其实,很可能明天的RNN变形、或RNN与TCN结合的模型、亦或是另一种完全不同结构的模型可以轻松超越现有深度结构:

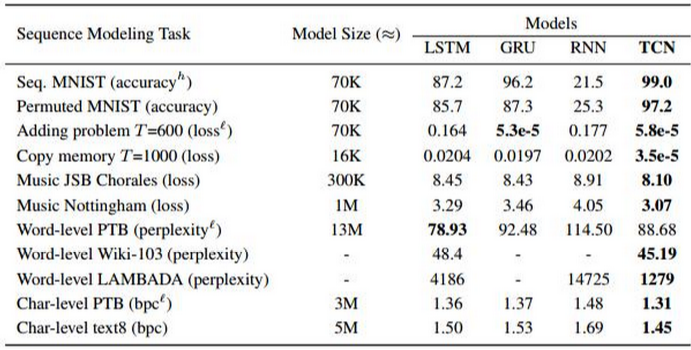

论文中TCN与其他递归神经网络的性能比较

况且,TCN提出的一部分原因是为了和现在有限的计算力做妥协(获得更快的计算速度),未来,RNN的密集计算或许不是问题。

技术讨论

技术讨论