深度学习,注定划过AI夜空的耀眼流星

【深度学习背景】

深度学习是近十年来人工智能领域取得的最重要的突破之一,它是通过建立起类似于人脑的分层模型结构,对输入数据逐级提取从底层到高层的特征,从而搭建好从底层信号到高层语义的映射关系。Hinton等人于2006年提出深度学习的概念,其灵感来源于人脑视觉系统:科学研究表明,人眼在观察环境物体的过程中,被观察对象的“边缘”和“方向”刺激了瞳孔,使大脑皮层里面的“方向选择性细胞”活跃,将视觉信息传递到大脑中枢,实现对物体的判别。从物体反射光线进入眼球到人脑识别物体的短暂时间间隔中,人体视觉系统必须迅速从“底层”的原始图像中逐层提取更抽象、更“高层”的信息供大脑做出判断。

【Master?Alpha Go?】

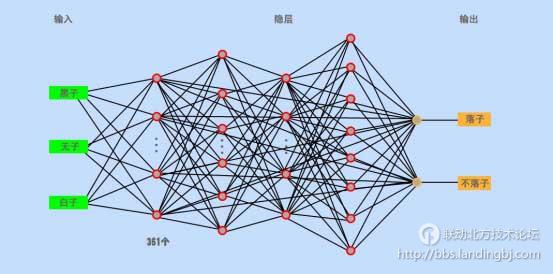

2017年元旦刚过,一位名叫Master的神秘棋士就频繁出现在中国的网络围棋室,悄无声息地收割对手。等人们惊觉有异的时候,它已经获得了50人连斩。于是,有人族最后的希望之称的柯杰,棋圣聂卫平等人纷纷上阵,但结果只是让Master的连斩记录提升到了60,无一败绩。最后,Google终于承认,Master就是它们的人工智能系统阿尔法狗。围棋一度被视为人类智慧最后的堡垒,原因是围棋的变化极为复杂,即便是算力无双的计算机,也无法穷尽黑白两子在棋盘里361个点位上的所有变化。所以,在计算机击败国际象棋大师之后,围棋就成为了某种象征。去年,阿尔法狗连续击败两位人族的职业棋士,给人们带来了很大的震撼。

AlphaGo使用的是蒙特卡洛树搜索(Monte Carlo tree search),借助值网络(value network)与策略网络(policynetwork)这两种深度神经网络,通过值网络来评估大量选点,并通过策略网络选择落点。AlphaGo的主要工作原理就是“深度学习”。它通过两个不同神经网络“大脑”(落子选择器和棋局评估器)合作来改进下棋,其中落子选择器观察棋盘布局企图找到最佳的下一步,而棋局评估器通过整体局面判断来辅助落子选择器,这样就能最大化的模拟人脑。但我们要弄清楚的是,Master的胜利在快棋上更有优势,如果是慢棋,在局势的判断上,即棋局评估器有可能会比较优势没那么明显。

下面让我们一起来探究探究深度学习。

【什么是深度学习?】

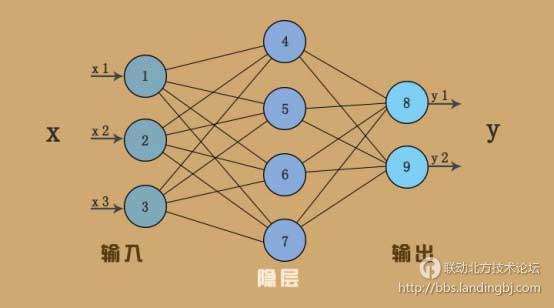

深度学习的概念源于人工神经网络的研究,它基于神经网络框架,通过模拟人脑学习的方式的来处理数据,通过神经网络的分层处理,将低层特征组合形成更加抽象的高层表示属性类别或特征,以发现数据的分布式特征表示。深度学习的体系结构是简单模块的多层堆栈,所有(或大部分)模块的目标是学习,还有许多计算非线性输入输出的映射。堆栈中的每个模块将其输入进行转换,以增加特征的可选择性和不变性。每一个神经元会对输入的信息进行权衡,确定权重,搞清它与所执行任务的关系,比如有多么正确或者多么不正确。最终的结果由所有权重来决定。每个神经元,通过某种特定的输出函数 ,计算处理来自其它相邻神经元的加权输入值。神经元之间的信息传递的强度,用所谓加权值来定义,算法会不断自我学习,调整这个加权值。

【深度学习网络:传统神经网络和深度神经网络】

传统的神经网络往往使用原始形式来处理自然数据,模型的学习能力受到很大的局限,构成一个模式识别或深度学习系统往往需要相当的专业知识来从原始数据 中(如图像的像素值)提取特征,并转换成一个适当的内部表示。而深度神经网络则具有自动提取特征的能力,它是一种针对表示的学习。深度神经网络允许多个处理层组成复杂计算模型,从而自动获取数据的表示与多个抽象级别。这些方法大大推动了语音识别,视觉识别物体,物体检测,药物发现和基因组学等领域的发展。通过使用BP算法,深度神经网络有能力发现在大的数据集的隐含的复杂结构。它能够从原始输入数据中自动发现需要检测的特征。

从早期的神经网络的学习,到现在的深度学习,究其机制,都是从模拟大脑的构架并辅以一定的学习算法,从而使计算机的工作方式尽可能地接近人类的工作方式。机器学习从仅有2层左右的学习构架,要向有多层的结构发展,不仅有生物神经元的启示,也是对现有的机器学习结构的弊端的改进。

首先,人类大脑的神经元系统是一个庞大的结构,由无数个神经元共同组成,完成一定的生理功能。例如,从视网膜到处理视网膜的大脑区域,需要经过无数层的神经元层层传递视觉信息,最终到达大脑的视觉处理区域,然后再经过信息处理,把信息反馈到肌肉神经,或语言区域。这个过程在生物神经元系统只不过是瞬间的事情,但是,完成这个过程,是由已经训练好的神经系统完成的,神经系统对整个过程的处理,与从出生到成人的认知过程是分不开的。而这一切,要用电脑来完成,不是构造简单的人工神经元就能够完成的,需要大规模的神经元组织和链接,并经过来自于外界信息的不断强化和训练。故从结构上,神经网络结构要加深。

其次,如果神经网络的层次不够深,那么,多项式级的参数个数能解决的问题就有可能需要指数级的参数个数。

最后,深度机器学习是数据分布式表示的必然结果。分布式表示系统是由一组信息计算单元共同完成的,每一个概念都由不止1个信息计算单元表示,而每一个信息计算单元也参与计算不止1个概念。

【深度学习的结构是什么?】

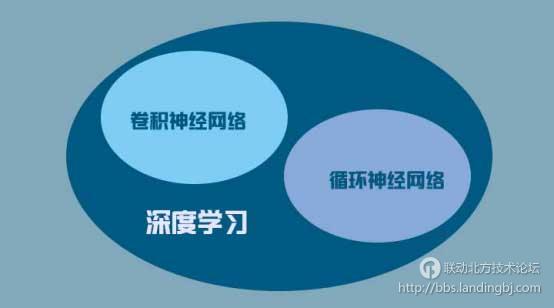

深度学习结构主要分为两种,一种是卷积神经网络,另一种是循环神经网络。

1.卷积神经网络

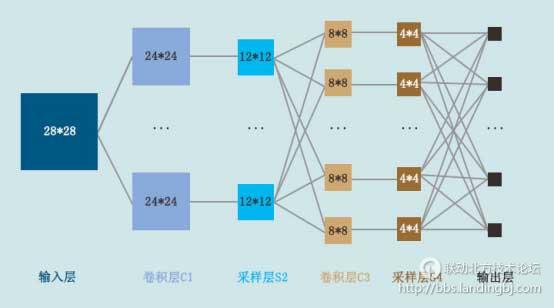

在深度神经网络中,卷积神经网络是参考人的视觉形成规律所构建的,因此常常用于图像识别;它是一种非全连接的神经网络结构,包含2种特殊的结构层:卷积层和次抽样层.卷积层由多个特征平面构成,完成抽取特征的任务.每个特征平面由神经元构成,在同一个特征平面上的所有神经元具有相同的连接权重。对于每个神经元,定义了相应的接受域,只接受从其接受域传输的信号.同一个特征平面的神经元的接受域具有相同的大小,故而每个神经元的连接矩阵相同。卷积神经网络是第一个真正成功训练多层网络结构的学习算法。它利用空间关系减少需要学习的参数数目以提高一般前向BP算法的训练性能。

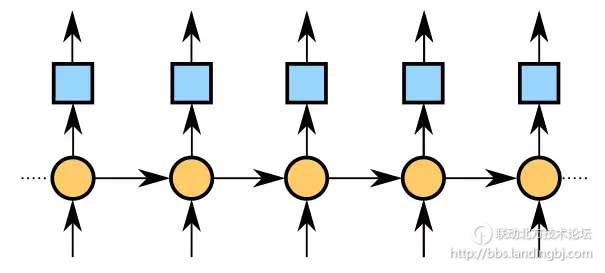

2.循环神经网络-语音/语义识别

循环神经网络,也被称为时间递归神经网络,是具有“记忆”的神经网络,因此常常用于联系上下文的语音识别,语义分析。语音识别与图像识别有两点不同,第一点,语音基本是一维的信息,语音识别以语调中的基本语素(最小的语音的声波频率)为主要识别信息,声音的大小和语气(声波的振幅)为辅,而图像识别是二维的平面信息;第二点,语音识别需要语境,通过上下文联系识别,这就需要“记忆”,而图像识别基本是即刻处理。循环神经网络的特点就是“循环”,系统的输出会以某种形式会保留在网络里, 和系统下一刻的输入一起共同决定下一刻的输出,此刻的状态包“记忆”,变成下一刻变化的依据。

对了,同机器学习方法一样,深度机器学习方法也有监督学习与无监督学习之分.不同的学习框架下建立的学习模型很是不同的。比如我们构建一个简单的识别植物的神经网络,就是先把菊花和梅花的数据准备好,再输入进去,这就是监督学习。假如不去告诉人工神经网络什么是对,什么是错,什么是菊花,什么是梅花,而是通过神经网络自己进行聚类学习,除了识别出一般的菊花梅花,甚至发现特殊品种,这种就是无监督学习,或者叫非监督学习。

【深度学习的必然局限性】

最近几年,深度学习在多个领域都产生了深远的影响,但与此同时也体现了它无可避免的局限性,列举以下几个方面:

第一,“隔行如隔山”,深度学习不会举一反三,AlphaGo下围棋能赢世界冠军,但是它如果改下象棋,它就成了白纸一张,所有训练出来的参数和权重似乎都没有了意义,无法跨行业利用;有点像从一个超级成熟的人,一下又被打回成婴儿原形(其实比这个更惨),而大家知道,儿童的学习成长和心智轨迹并不是这样的,所以它不具有人类这种触类旁通的能力。

第二,“墨守竟成规”,如上所述,即使不跨行,比如从围棋进入象棋;而是在同一行内有了新的输入通道,增加了新的维度的数据,比如棋盘象四国军旗一样,多了几块凸起的区域,它就得从头再学;因为它是黑箱的蛮练蛮算蛮学,针对特定输入和特定输出,耦合出来的各种权重参数,特别适合“死做题”、“做死题”;比较极端一点,可以看作是深度学习自身深入学习的能力的问题,现在所有的深度神经网络学习的方法,一旦网络结构变化,它的学习过程都是要从头开始学,要把数据重新进行一次训练。这跟人的学习能力相比确实有很大的差距,人的知识具有累加性的,而且常常发生“量变到质变”。

第三,“蛮力非智力”,不管有多么好的“学习能力”,不管有多么好的神经网络模型,深度学习本质上的问题还是通过算力,计算能力去解决大数据;更多的大数据,更大的计算能力,去做更好的融合的过程。就像以前文章论述过的,计算的组合爆炸是阶乘增长的,速度超过了硬件增长的摩尔定律,所以在未来更多的参数下面,它还有没有这种能力,达到计算的效果,这要打上很大的问号。而且过度强调算力,很容易陷入过度拟合,即处理不好抖动问题和异常噪声干扰,也无法很好的推理和变通;象AlphaGo和李世石对战的第4场,就是输掉的那一场,深度网络的这个问题,非常明显的暴露了出来。

“知识就是力量”常常听到,但很少听说“力量就是知识”。

第四,“现实很骨感”,深度学习的出现虽然挑战了一些计算机语音和视觉,大大降低了计算机语音和视觉识别的误差率,但距离工业级依旧遥远。对于当前的实现方式,比如从70~80%提升到90%相对容易,但从90%提升到99%特别特别难,意味着总是看上去不错,离大规模普及使用似乎又总是永远差那么一步;再比如对于清理桌子我们觉得很简单,但对于机器人和计算机来讲它们会做得特别差。

(题外多啰嗦一句,对于可穷举,可暴力计算的博弈问题,以及可确定概率最优的博弈问题,使用深度学习属于典型的画蛇添足。在不完全信息的局面下,人类存在的一些狡黠特性是深度学习要面临的,如果你数学足够好,不用深度学习也可以试着去研究赌场的漏洞;如果你数学不够好,用了深度学习你也玩不过赌场请的数学家)

所以,深度学习从来都并不是真正的人类学习,只是通过大量训练集,使自己的外在表观看起来象似人类学习。过于神话深度学习并没有意义,网上有一种言论,把深度学习当作包治百病的技术,这就有失偏颇了。

【结语】

深度学习,纵使在夜空中大放异彩的耀眼,然而注定只是划过的一颗流星;真正的北斗星和南十字星,并不在夺目之明廊,而在当下之暗处。

------华丽的分割线------

欢迎登陆联动北方技术论坛去讨论关于人工智能的话题哟,还有大奖等你拿!点击【参加活动】即可跳转

该贴由system转至本版2017-3-29 12:42:14

技术讨论

技术讨论