玩过了云应用,再来玩玩粉火的hadoop~~~这篇主要写的是hadoop与hive组件在单机上的配置,废话不多讲,开始~~~

一、系统运行环境

操作系统环境:Linux版本 CentOS 6.0 Desktop

Hadoop版本: Hadoop 0.20.2 下载地址:http://www.apache.org/dyn/closer.cgi/hadoop/core/

Hive 版本: Hive-0.8.0-bin 下载地址:http://www.apache.org/dyn/closer.cgi/hive/

二、配置步骤

通用环境配置

默认最小化安装,所以系统里面没有包含JAVA,由于Hadoop 0.20.2的JDK版本只需要1.6的,所以在我这个情况下是不需要到sun网站去手动下载jdk了,只需要在Termial中输入: yum install java java-1.6.0-openjdk-devel

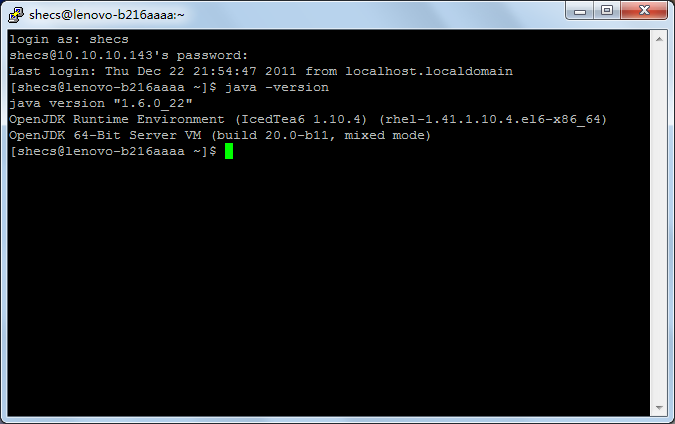

安装完Java之后用命令: java -version 验证java是否正确安装,如下图所示,OK。

装完Java之后我们还要确认有没有安装sshd服务和ssh客户端工具,默认ssh已经安装,因此我们只要再安装一下rsync。

输入命令: yum install rsync

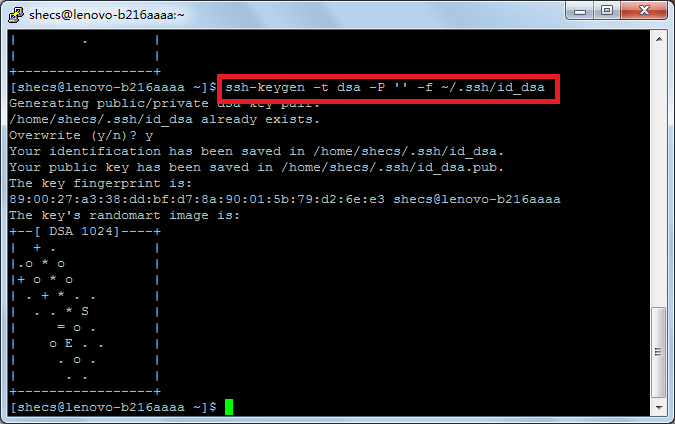

再确认可以用ssh免密码登录localhost

输入ssh localhost命令: ssh localhost

ssh-keygen -t dsa -P ” -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

注意:-P 后面为两个“ ‘ ”号,代表密码设为空

上述配置完成后进入解压,配置Hadoop阶段

1.解压hadoop包

输入命令 :tar zxf hadoop-0.20.2.tar.gz

进入解压后的hadoop目录

cd hadoop-0.20.2

2.修改hadoop的配置文件

a.设置JAVA_HOME

编辑conf/hadoop-env.sh文件,找到:# export JAVA_HOME=/usr/lib/j2sdk1.5-sun 把前面的注释符号#去掉,等号后面的路径改为你���JDK所在的目录,如你的java可执行文件在/usr/bin/java,则写成(不要包含bin):

export JAVA_HOME=/usr

注意:如果不知道java在什么地方请用whereis java查询

b.配置hadoop的单机集群模式(伪集群模式)

修改conf/core-site.xml,内容改为:

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

修改conf/hdfs-site.xml,内容改为:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

修改conf/mapred-site.xml,内容改为:

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

c.初始化hadoop Namenode

执行:bin/hadoop namenode –format

bin/hadoop namenode -format

d.启动运行hadoop

执行:bin/start-all.sh

等到所有进程都执行后继续

注意:可以用jps命令看一下启动了哪些java进程:一般有以下几个进程TaskTracker,SecondaryNameNode,JobTracker,Jps,NameNode,DataNode

Hadoop安装成功

Hadoop配置完成后开始配置HIVE

一、在HDFS中建立hive要用的目录

输入命令:

bin/hadoop fs -mkdir /tmp

bin/hadoop fs -mkdir /user/hive/warehouse

bin/hadoop fs -chmod g+w /tmp

bin/hadoop fs -chmod g+w /user/hive/warehouse

二、解压Hive

tar zxf hive-0.8.0-bin.tar.gz

cd hive-0.8.0-bin

三、设置HADOOP_HOME

export HADOOP_HOME=/home/chin/hadoop-0.20.2

四、运行Hive

bin/hive

hive >

Hive运行成功,配置轻松惬意啊,用的时间还没写博的时间多,不过这个配置过程只针对hadoop0.20.2,最新的hadoop0.23conf结构已经发生了���变,不过没啥关系,配置的时候对照相应官方参考手册就行了~

技术讨论

技术讨论